Une présentation reprise du site Framablog, un site sous licence Creatave Commons

Christophe Masutti est membre de Framasoft, en charge notamment du projet Framabook, notre collection de livres libres autour du Libre. « Livres libres », cela signifie que les ouvrages sont sous licences libres, ce qui a pour effet de maximaliser leur diffusion.

Il est également universitaire et à ce titre acteur et auteur de publications scientifiques. Son expérience, sa pratique et sa rigueur professionnelles nourissent le projet Framabook.

Mais pourquoi, dans l’autre sens, la publication scientifique ne tirerait pas aussi profit du « modèle Framabook » ? Pourquoi ne s’inspirerait-elle pas de ce qui fait la force et la sève du logiciel libre ?

Parce qu’il faut bien le reconnaître, la situation actuelle en est fort éloignée, jusqu’à évoquer, là encore, un « gigantesque Minitel 2.0 ». Alors que les nouvelles technologies et Internet promettent bien plus que cela.

Dans cet article clair, précis, accessible et documenté, Christophe Masutti pose les jalons d’un avenir possible et souhaitable de la publication scientifique, un accès à la connaissance réellement au service et au bénéfice de tous.

Pour libérer les sciences

Le document PDF dans son intégralité

Christophe Masutti - 15 décembre 2010 - version 1.0 - Licence Creative Commons By SA (version 2.0 France). Emplacement : http://linuxetleschoses. tuxfamily....)

Préambule

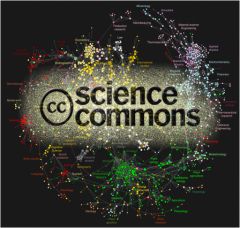

L’objectif de ce texte est de faire valoir l’intérêt d’une diffusion décentralisée et libre des connaissances scientifiques. En partant de l’idée selon laquelle l’information scientifique n’a d’autre but que d’être diffusée au plus grand nombre et sans entraves, je montrerai les limites du système classique de publication à l’ère du format numérique, ainsi que les insuffisances des systèmes d’archives « ouvertes ». J’opposerai le principe de la priorité de la diffusion et à l’aide de quelques exemples, j’aborderai la manière dont les licences libres Creative Commons permettent de sortir de l’impasse du modèle dominant.

Ce document est un document martyr et une large place est réservée à l’opinion de son auteur. N’étant pas spécialiste des aspects juridiques concernant les droits d’auteur, certaines affirmations pourront sembler approximatives voire complètement fausses. Si c’est le cas, n’hésitez pas à le signaler par courriel (NdE : ou dans les commentaires ci-dessous).

Sommaire

- 1 Introduction 2

- 2 La centralisation 2

- 3 L’accès gratuit 4

- 4 Les politiques éditoriales 5

- 5 Propriété et pénurie 6

- 6 Principe de priorité de la diffusion 8

- 7 Trois exemples 10

- 8 Droit d’auteur 12

- 9 Universalisme et liberté 14

- 10 La Déclaration de Berlin 15

- 11 Aspects pratiques 17

re-publicationsur a-brest en deux articles compte tenu de la longueur du texte dans le suivant les parties 6à 11

1 Introduction

En juillet 2010, l’Organisation européenne pour la recherche nucléaire fit un communiqué

apparemment surprenant. Déclarant supporter officiellement l’initiative Creative

Commons, elle annonça que les résultats publiables des recherches menées au LHC (Large

Hadron Collider – l’accélérateur de particules inauguré en 2008) seraient diffusés sous les

termes des licences libres Creative Commons, c’est-à-dire [1] :

« des autorisations non exclusives qui permettent aux titulaires de droits d’autoriser

le public à effectuer certaines utilisations, tout en ayant la possibilité de réserver

les exploitations commerciales, les oeuvres dérivées ou le degré de liberté. »

En réalité, la surprise était en partie attendue . En effet, le CERN [2] fut pour beaucoup

dans l’apparition de l’Internet et le rôle qu’y jouèrent Tim Berners Lee et Robert Cailliau,

inventeurs du système hypertexte en 1989, fut décisif. Le fait de diffuser les résultats

du LHC sous licence libre obéit donc à une certaine logique, celle de la diffusion et de

l’accessibilité de l’information scientifique sous format numérique. La dématérialisation des

publications scientifiques et leur accessibilité mondiale, pour un coût négligeable grâce

à Internet, permet de se passer des mécanismes de publication par revues interposées,

avec cession exclusive de droit d’auteur, et réputés lents, coûteux, et centralisés. Dans

ce contexte, le CERN a opté pour une diffusion décentralisée (en définissant a priori les

conditions d’exercice des droits d’exploitation favorisant le partage) tout en garantissant

la paternité et l’intégralité (les droits moraux) des travaux scientifiques.

Plus récemment encore, en novembre 2010, M. P. Rutter et J. Sellman, de l’Université

d’Harvard, ont publié un article intitulé « Uncovering open access » [3], où ils défendent

l’idée selon laquelle le libre accès aux informations scientifiques permet de resituer le lien

entre savoir et bien commun. Pour amorcer leur argumentaire, l’étude de cas – désormais

classique en histoire de la génétique – de la « redécouverte » des expérimentations de

Gregor Mendel sert à démontrer à quel point les sciences sont « assujetties à la diffusion ».

Là encore, il s’agit de mettre en perspective la question de la disponibilité des informations

scientifiques à travers les systèmes centralisés de publications.

L’exemple des accords

difficiles entre le Max Planck Institüt et le groupe Springer pour l’accès à quelques 1200

revues est illustratif de la tension permanente entre le coût des abonnements, les besoins

des chercheurs et l’idée que les connaissances scientifiques devraient être accessibles pour

tous.

Dans un monde où la production et la diffusion des connaissances dépendent essentiellement

de l’outil informatique (production et communication de données dans toutes

les disciplines), la maîtrise des technologies de stockage et du web sont des conditions

essentielles pour garantir le transfert et l’accessibilité. Aujourd’hui, en profitant des plus récentes

avancées technologiques, tout un chacun est capable d’échanger avec les membres

de sa famille et ses amis un grand volume de données en tout genre via Internet. Il devrait

donc logiquement en être de même pour les travaux scientifiques, pour lesquels l’échange

d’information est d’une importance vitale. Ce n’est toutefois pas le cas.

2 La centralisation

La production, la diffusion et l’accès à nos connaissances scientifiques sont formalisés

par les outils informatiques :

- la production : nul chercheur ne saurait aujourd’hui travailler sans Internet et encore

moins sans un ordinateur dans lequel il classe, construit et communique ;

- la diffusion : aujourd’hui, un article scientifique peut rester, de sa production à sa

lecture finale, dans un circuit numérique sans jamais en sortir ;

- l’accès : nous profitons tous des multiples services qui nous permettent, notamment

par Internet, d’accéder rapidement à l’information, beaucoup plus rapidement qu’il

y a à peine vingt ans. Le rythme de la recherche s’accélère et la numérisation des

connaissances n’y est pas pour rien.

Pour rendre cohérent ce système de production et de diffusion, l’ingénierie informatique

a joué un rôle fondamental dans la création des moyens par lesquels nous ordonnons

nos connaissances : le système hypertexte, l’introduction de la logique booléenne, les

outils d’indexation de données, etc. De même, la réduction du temps de transmission

de l’information, grâce, par exemple, aux nanotechnologies ou encore au clustering de

serveurs, joue un rôle primordial dans l’efficacité de nos systèmes d’échanges d’informations.

Ces innovations ont donc produit quelque chose de très positif dans la mesure où,

profitant de ces avancées techniques majeures, nous réduisons de plus en plus les délais

de communication des données scientifiques, ce qui optimise la production de nouvelles

connaissances.

La production, la diffusion et l’accès à nos connaissances ont donc épousé un ordre numérique

hautement performant, et l’on pourrait redouter que la maîtrise de cet ordre soit

avant tout une maîtrise des moyens. Il s’avère que non. Excepté pour les expérimentations

nécessitant, par exemple, l’utilisation de supercalculateurs, la maîtrise des outils informatiques

en général ne préjuge pas du « rendement » scientifique, elle ne fait qu’optimiser la

communication des résultats. Les « maîtres » du nouvel ordre numérique ont donc déployé

une stratégie qui a toujours fait ses preuves : centraliser les données et conditionner leur

accès.

C’est ce qui s’est produit dans le cas d’Internet : alors même qu’Internet est d’abord

un système décentralisé où chacun communique des données avec tous les autres, la

possession des données et le calibrage de leur accès par les acteurs de l’économie du web

a transformé Internet en un gigantesque Minitel 2.0 [4] car il est inscrit dans une

certaine tradition de la communauté des chercheurs qui le fréquentent et y déposent

presque systématiquement leurs productions. Il a ses limites, tout comme l’ensemble des

initiatives d’accès gratuit aux ressources : aucun n’a de politique véritablement claire à

propos du droit d’auteur.

4 Les politiques éditoriales

Le projet Sherpaest une source d’information très utile pour connaître les politiques

éditoriales des maisons de publications. La liste Romeo, en particulier, recense les possibilités

et les conditions de dépôt des productions dans un système d’archives ouvertes.

Selon les revues et les conditions imposées par les éditeurs, il est possible pour un auteur

d’archiver une version preprint ou postprint de son article. Un classement des revues par

couleur (blanc, jaune, bleu et vert) signale les niveaux d’autorisation donnés aux auteurs

afin qu’ils puisse disposer de leur travail après avoir toutefois cédé une partie de leurs

droits d’auteur.

Le fait que la majorité des revues scientifiques aient des politiques de droit d’auteur

différentes n’est guère surprenant. Outre les « grandes » revues classées dans les premiers

rangs mondiaux, on trouve parfois des centaines de revues spécialisées selon les disciplines,

apparaissant (et parfois disparaissant) selon la vie des communautés de chercheurs. Un

peu d’histoire des sciences nous apprend que lorsqu’une discipline ou un champ d’étude

apparaît, le fait que la communauté puisse disposer d’un espace de publication propre

marque souvent les débuts d’une forme d’institutionnalisation de ce champ d’étude et,

donc, une forme de reconnaissance par le reste de la communauté scientifique. La longévité

et la fréquence de parution des revues peuvent être considérées comme des indicateurs de

croissance de ce champ d’étude au cours de son histoire. Par conséquent, la multiplicité

des revues, dans la mesure où se trouvent des groupes de chercheurs assez motivés pour

les maintenir en termes de moyens techniques, humains et financiers, est plutôt un élément

positif, signe d’une bonne santé de l’activité scientifique, et une forme de garantie

démocratique de l’accès aux connaissances. Si toutes ces revues ont des politiques de

droit d’auteur différentes c’est aussi parce qu’elles ont des moyens divers de subsistance,

et, bien souvent, la seule vente des exemplaires papier ne suffit pas à couvrir les frais de

publication.

Un autre élément qui conditionne en partie les politiques éditoriales, c’est le flux des

publications scientifiques. Paradoxalement, le nombre actuel des revues ne saurait suffire

à absorber les productions scientifiques toujours plus nombreuses [5] . Outre les phénomènes

de compétitions entre pays, ce nombre est principalement dû aux politiques de recherche

et à la culture de l’évaluation des chercheurs selon laquelle le nombre de publications est

devenu un indicateur de qualité de la recherche, faute d’avoir des évaluateurs capables de

(et autorisé à) juger précisément de la pertinence et de la valeur scientifique du contenu

des publications. Or, ces politiques d’évaluation de la recherche impliquent pour les chercheurs

la nécessité de publier dans des revues dont le classement, établi par ces mêmes

évaluateurs, préjuge de la qualité scientifique du contenu.

Toutes les revues ne sont pas classées, à commencer par les petites revues connues

dans les champs d’étude émergents et qui sont bien souvent les principaux supports de

communication des recherches les plus novatrices et des nouvelles niches intellectuellement

stimulantes. Finalement, les revues classées, et surtout celles qui disposent d’un classement

élevé, ne peuvent absorber tout le flux des productions. Cette pression entre le flux et les

capacités concrètes de publication implique une sélection drastique, par l’expertise (les

reviewers ou referees), des articles acceptés à la publication. Comme cette sélection est

la garantie a priori de la qualité, le classement se maintien alors en l’état. On comprend

mieux, dès lors, pourquoi ces revues tiennent non seulement à ce que les auteurs leur

cèdent leurs droits pour exploiter les contenus, mais aussi à ce que ces contenus soient le

moins visibles ailleurs que dans leur propre système de publication et d’archivage. Nous

revenons au problème de la centralisation.

5 Propriété et pénurie

Si nous mettons en perspective la croissance des publications scientifiques, le besoin

d’évaluation, la nécessité (individuelle de la part des chercheurs, ou concurrentielle au

niveau des universités et des pays) du ranking qui privilégie quelques revues identifiées

au détriment des plus petites et discrètes, et l’appropriation des moyens de diffusion par

les conglomérats du marché scientifique, nous assistons à l’organisation d’une pénurie

maîtrisée de l’information scientifique.

J’évacue aussitôt un malentendu. Cette pénurie est maîtrisée dans le sens où l’information

scientifique est en général toujours accessible, mais ce sont les conditions de cette

accessibilité qui sont discutables.

Prenons un cas concret. Jstor (Journal Storage) est une organisation américaine à but

non lucratif, fondée en 1995, dans le but de numériser et d’archiver les revues académiques.

Créé pour permettre aux Universités de faire face à l’augmentation des revues, Jstor soustraite

l’accessibilité et le stockage de ces revues, assurant ainsi un rôle de gardien de la

mémoire documentaire scientifique. Le coût de l’abonnement à Jstor est variable et ne

figure certainement pas parmi les plus chers. En revanche, dans le cadre de l’archivage et

des conditions d’accessibilité, des accords doivent se passer entre les revues détentrices des

droits de publication et Jstor. Ainsi, la disponibilité des revues est soumise à une barrière

mobile (moving wall) qui détermine un délai entre le numéro en cours de la revue et le

premier numéro accessible en ligne. Quel que soit ce délai, un article scientifique devra

toujours être payé : soit en achetant la revue au format papier, soit en achetant l’article

au format électronique sur le site de la revue en question, soit en achetant un abonnement

auprès de Jstor dans le cas où le numéro de la revue en question y est accessible.

Dans d’autres cas de figure, les articles scientifiques peuvent être trouvés et vendus

au format numérique sur plusieurs espaces à la fois : sur le site de la revue, sur un site de

rediffusion numérique (comme par exemple le service Cat.Inist du CNRS), ou en passant

par le service d’abonnement d’une institution (Jstor, Elsevier. . . ).

Jamais auparavant on n’avait assisté à une telle redondance dans l’offre de publication

du marché scientifique. En conséquence, surtout avec l’arrivée du service de vente d’articles

à l’unité, jamais le marché de la publication scientifique n’a obtenu un tel chiffre d’affaire.

Est-ce synonyme d’abondance ? Pas vraiment. L’inégalité de traitement entre les revues est

toujours un obstacle qui prive les nombreuses « petites » revues (qui peuvent toutefois être

célèbres mais dont le marché n’a bien souvent qu’une dimension nationale) de participer

à l’offre. Dans la plupart des cas, les articles scientifiques publiés dans ces conditions sont

donc archivés d’une manière ou d’une autre, mais sur un marché séparé, parfois sur le

site internet propre à la revue, parfois sur les serveurs d’un regroupement non lucratif

de revues, géré la plupart du temps par des institutions publiques, comme par exemple

Revues.org.

Par ailleurs, un autre obstacle est préoccupant : le temps de latence variable d’une

revue à l’autre entre la publication papier et l’accès aux versions numériques. Ce temps

de latence est dû à deux écueils qu’il me faut maintenant longuement développer.

Le premier est la conception rigide que l’on a du format numérique, à savoir que la

version numérique d’un document est considérée comme une copie de la version papier.

Ce n’est pas le cas. Fort heureusement, la plupart des maisons d’éditions l’ont compris :

un article peut être mis sous format HTML, avec un rendu dynamique des liens et de la

bibliographie, par exemple, ce qui lui apporte une dimension supplémentaire par rapport à

la version papier. Or, c’est cette conception du document-copie numérique qui prime, par

exemple, dans le cas de Jstor, ou encore dans celui de certains projets de numérisation

de la BNF, car l’objectif est d’abord de stocker, centraliser et d’ouvrir l’accès. Certes,

la numérisation de fonds anciens ne peut transformer les articles en pages dynamiques

(quoique les récentes avancées dans le domaine de la numérisation de fonds tendrait à

montrer le contraire). En revanche pour les numéros plus récents, qui de de toute façon ont

été rédigés de manière électronique par leurs auteurs, la « barrière mobile » implique bien

souvent que pendant quelques années un article ne sera disponible qu’au format papier

alors que rien ne l’y contraint techniquement. Cela représente une perte considérable dans

notre monde numérique ! Dans le cas d’une revue bi-annuelle à faible tirage, il devient

très difficile de se procurer un numéro un ou deux ans après sa parution (phénomène qui

pourrait être mieux contrôlé avec les systèmes d’impression à la demande dont il sera

question plus tard). Et il faut attendre sa mise à disposition sur Internet (gratuitement

ou non), pour que cet article touche enfin le potentiel immense du nombre de lecteurs à

travers le monde. . . à ceci près qu’il y a toujours un temps de latence et qu’en moins de

deux ans, un article peut voir très vite son intérêt scientifique diminuer, et avec lui l’intérêt

de la mise en ligne, si ce n’est uniquement pour son archivage. Ce temps de latence, cette

« barrière mobile », peut très facilement disparaître pour peu que l’on s’interroge sur le

réel intérêt de la cession des droits d’auteur (de diffusion) des articles scientifiques.

C’est ce qui m’amène au second écueil : la question des droits d’auteur et de diffusion.

Pour qu’une revue « papier » soit rentable, ou du moins qu’elle résiste à la pression entre

l’investissement et les frais de fonctionnement, il faut qu’elle puisse vendre un certain

nombre de copies. Pour que cette vente puisse se faire, tout le monde part du principe

que les auteurs doivent céder une partie de leurs droits à l’éditeur (une cession exclusive).

Avec l’apparition des licences libres de type Creative Commons, nous verrons que ce n’est

nullement là une condition nécessaire. L’autre aspect de cette cession de droit est que

l’auteur ne peut plus disposer de son travail (son oeuvre) comme il l’entend. La diffusion

de cette oeuvre est donc soumise à la politique éditoriale de la revue qui ne s’engage

pas obligatoirement à en garantir l’accessibilité numérique. En revanche, la cession des

droits permet aux revues de réaliser une plus-value supplémentaire dans le cadre de la

diffusion numérique, par exemple en passant des accords avec un grand distributeur de

revues électroniques. Là encore, le biais est à redouter dans la mesure où les abonnements

ont un coût bien souvent prohibitif pour les institutions qui les payent, ce qui fait souvent

l’objet de discussions serrées.

Avec l’émergence des premiers périodiques électroniques, les éditeurs ont massivement

investi dans l’économie numérique, en répercutant ces coûts sur les abonnements.

Pour donner un exemple, le prix annoncé par l’Université de Poitiers pour un abonnement

à Elsevier-Science Direct est de 37556 euros pour l’année 2007, un coût apparemment

raisonable mais qui ne cesse d’augmenter et doit être multiplié par le nombre d’abonnements

différents d’une même université [6]. Pour pallier ces frais toujours croissants les

institutions se sont organisées en consortia, de manière à mutualiser ces coûts. Mais cela

ne vaut que pour les groupements capables de faire face aux éditeurs. En effet, certains

pays se heurtent à une réduction des fonds publics dédiés à la recherche, et d’autres

pays, comme ceux en voie de développement, n’ont bien souvent pas les moyens de payer

ces abonnements. En fait, il y a là encore une différence de traitement dans l’accès à

l’information scientifique, et sans doute la plus révoltante : dans la mesure où l’accès

aux ressources numériques représente bien davantage, d’un point de vue technique et de

traitement de l’information, qu’un simple accès à un abonnement « papier », comment

peut-on concevoir qu’une partie loin d’être négligeable des informations scientifiques sous

forme électronique puisse ne pas être accessible à certaines parties du monde ? Et au sein

d’un même pays, comment accepter qu’il puisse exister une inégalité d’accès entre les

différentes institutions, entre celles qui ont les moyens financiers suffisants et les autres,

ou entre celles qui, faisant partie de tel consortia, n’ont pas accès aux mêmes revues que

les autres ?

Certes, on me rétorquera que les abonnements aux revues « papier » ont toujours été

chers eux aussi, de même que le stockage de ces revues. Ce à quoi je réponds :

1. le format numérique ne coûte rien à la production (les revues externalisent les coûts

de mise en page chez les auteurs eux-mêmes, et ont tendance à ne jamais payer les

auteurs ni les membres des comités de sélection des articles), c’est le stockage et la

gestion sur les serveurs privés d’un conglomérat qui représente un coût,

2. ce stockage en un seul endroit dont l’accès est payant n’apporte rien de plus à la

qualité de l’information scientifique,

3. classement et ordonnancement de l’information scientifique dépendent du distributeur,

et ne sont donc pas neutres scientifiquement (certaines revues disparaissent ou

apparaissent dans les catalogues suivant les transactions ou les intérêts du moment),

4. les productions scientifique devraient donc circuler librement dans les communautés

scientifiques sans dépendre de services tiers, du moins non publics.

Il ressort de tout cela que l’accès à l’information scientifique souffre gravement d’un

manque d’efficacité. Les mouvements du type « archives ouvertes » se contentent finalement

de transformer l’information en archive, justement, c’est à dire la forme la moins

exploitable de l’information scientifique. En effet, dans la mesure où l’accessibilité à l’information

sous forme numérique en temps et en heure dépend d’un marché de diffusion

fermé, dont sont exclus des pans entiers de la connaissance (les revues « papier » et parfois

numériques mais dotées de peu de moyens ou n’appartenant pas à un conglomérat), on

traite l’article scientifique au format numérique comme une copie de sa version « validée »,

parfois plusieurs années après, au titre d’archive de la connaissance.

En somme, on fait

de la mémoire documentaire, au lieu d’assurer la diffusion des connaissances au moment

où elles se créent. Or, si un groupe comme Elsevier Science Direct regroupe environ 2000

périodiques, comment est assurée la diffusion des autres revues ? Nous avons vu leur inégalité

de traitement. La « barrière mobile » séparant, pour un article, sa publication de

son archivage, crée donc une grande inégalité entre les articles pouvant être diffusés par

les revues cotées ou appartenant à des groupements de diffusion, et ceux des revues moins

cotées, sachant que la rareté induite par les mécanismes de classement (on ne peut classer

toutes les revues) est aussi une cause de cette inégalité de traitement et de fermeture du

marché. Ma conclusion, pour cette partie, tient en une seule affirmation : il faut rendre la

priorité à la diffusion sur la publication. Mais sous quelles conditions ?