D’après Émilien Ruiz, les humanités numériques se trouvent “à la croisée des chemins”. Cette communauté transdisciplinaire a émergé depuis plus de 10 ans, soit suffisamment de temps pour que les pratiques du futur deviennent celles du présent. Ou pas…

Car si les humanités numériques se sont ancrées institutionnellement, les promesses de renouveau scientifique et pédagogique restent encore à l’état de perspectives plus ou moins lointaines : « à ce stade, il me semble pourtant qu’il est possible de parler d’un demi-échec ». Les enseignements du numérique demeurent périphériques. Il y a eu une inflexion réelle dans les pratiques de recherche, les bases de données et les corpus en ligne devenant de plus en plus des outils “normaux” et attendus, mais avec finalement peu d’incidence sur les méthodes et sur les manières d’aborder et de construire l’objet de recherche. Au plus une révolution de l’indexation scientifique, mais certainement pas une révolution scientifique.

Émilien remarque avec justesse que ce bilan en demi-teinte a eu une incidence sur la définition-même des humanités numériques. La dimension quantitative et “computationnelle” a été progressivement reléguée au second plan, au profit d’une approche communicationnelle mettant l’accent sur l’éditorialisation et la diffusion des résultats. Les humanités numériques apparaissent davantage comme une étape supplémentaire dans le cycle de la recherche, sans altérer en profondeur l’existant.

À ce stade, l’on peut légitimement se demander si l’ambition principale des humanités numériques ne devraient pas être de “disparaître”. Réagissant au constat d’Émilien, Paul Bertrand appelle à la « fin nécessaire et heureuse des humanités numériques », appelées à se dissoudre dans les disciplines existantes. Si l’on se limite au versant communicationnel et éditorial des humanités numériques, cette réaction est amplement justifiée. Créer un site ou un carnet de recherche, alimenter une base de données, formater et visualiser un corpus devraient effectivement faire partie de l’outillage ordinaire des disciplines.

Mes recherches en cours m’amènent de plus en plus à faire le constat inverse : toutes les humanités numériques ne sont pas solubles. Ou plutôt, dans ce mouvement volontairement vague et informe, quelque chose a émergé qui change notre rapport aux objets, au savoir. Quelque chose qui ne représente qu’une partie humanités numériques mais qui resterait mêmes si toutes les pratiques estampillées DH venaient à se normaliser et à rentrer dans le giron de leurs disciplines d’origine. Quelque chose qui réactualise la dimension quantitative marginalisée mais en faisant autre chose que “l’histoire quantitative”.

Cette approche n’a pas vraiment de nom, ou plutôt, les labels existants ne sont pas satisfaisants : il est tantôt question de « computational literature studies » (sauf que cela ne se limite absolument à la littérature), de « lecture distante » (sauf qu’une part essentiel de la recherche actuelle porte sur des objets qui ne sont pas lus mais vus) ou de « cultural analytics » (expression qui se traduit terriblement mal en français et, sans doute, dans d’autres langues européennes). On pourrait aussi tenter une définition purement SHS, sans jamais faire allusion à l’informatique et parler, par exemple, de « poétique historique des formes culturelles »

À défaut de nom, l’approche se caractérise par une intégration croissante de pratiques, de concepts, d’outils et de méthodes, plus ou moins marquées selon les contextes. Aux États-Unis il existe une revue dédiée qui fédère une petite communauté très active, le Journal of Cultural Analytics. En France les initiatives demeurent encore assez isolées.

De la numérisation à l’identification des régularités…

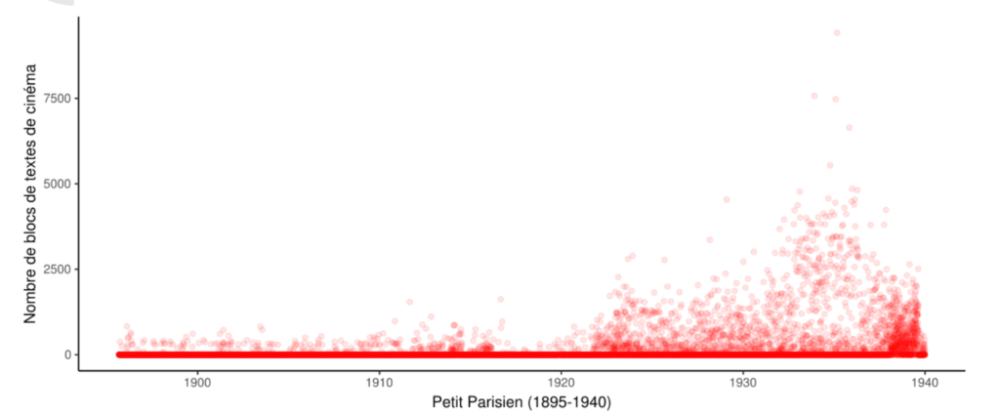

Le point de départ fondamental, c’est la numérisation de masse. Les bibliothèques numériques contiennent aujourd’hui une part substantielle des productions imprimées voire écrites. Je dispose ainsi d’environ un quart des éditions de romans de 1800 à 1900 (soit la totalité de ceux qui ont été numérisés par Gallica). Dans le cadre du projet Numapresse, nous commençons à réunir une bonne partie de la presse quotidienne nationale.

Si nous sommes encore loin de l’idéal d’une numérisation totale (qui ne relève néanmoins plus de l’utopie à moyen terme), il y a aujourd’hui suffisamment de ressources accessibles pour mettre en évidence des phénomènes culturels réguliers qui débordent totalement des narrations historiques courantes. Il existe des récurrences dans les manières d’écrire, dans les arrangements éditoriaux des textes, dans les figures visuelles (d’où d’ailleurs la notion de “stéréotype”). Par exemple, à partir du début du XIXe siècle, la presse française introduit un objet éditorial, le feuilleton, sorte de supplément interne au journal, où va notamment se nicher le roman-feuilleton. Ce qui est moins connu et qui a été rendu pleinement visible par la numérisation de collections très variées, c’est que la forme feuilleton va s’exporter dans une bonne partie de l’Europe continentale et sans doute au-delà mais pas dans les pays anglo-saxon.

Ces régularités constituent autant un standard documentaire qu’un fait social : à un certain moment, il va de soi que l’on va composer un texte d’une certaine façon, l’illustrer d’une certaine manière, à partir du moment où l’on souhaite aborder tel thématique et s’adresser à tel public.

À partir du moment où il est question de “régularités” et de “récurrences” il devient envisageable d’utiliser des méthodes quantitatives. On peut compter les feuilletons tout comme on peut compter les titres de romans qui mentionnent un genre précis, par exemple “roman de mœurs”, dans leur titre. Et à partir de ces décomptes l’on peut commencer à observer des tendances temporelles et/ou des répartitions géographiques.

Compter à la main de tels objets est une activité plutôt rébarbative même si elle a été pratiquée dans certains domaines (comme les media studies). La numérisation rend possible de déléguer cette activité à des outils automatisés. Dans certains cas, les calculs sont triviaux : compter des occurrences, agréger des publications, dessiner un graphe de tendance… Rapidement, il devient nécessaire d’utiliser des outils plus complexes.

Historiciser par algorithme

Certaines régularités peuvent en effet apparaître évidentes à un œil humain, a fortiori un peu familier du contexte culturel d’origine du document. Je sais reconnaître le feuilleton d’un journal presque instantanément. Créer une définition du feuilleton ou de la note de bas-de-page qui soit compréhensible pour un outil automatisé est une tâche beaucoup plus ardue — on parle aussi d’opérationnalisation. Cela suppose de réfléchir sur un regard qui semble de prime abord spontané : « qu’est-ce que je vois précisément lorsque je distingue un feuilleton ? ».

Il est possible de fournir des règles précises pour repérer les objets (c’est ce que l’on appelle une approche « rule-based ») ou au contraire de laisser l’outil informatique extrapoler les règles à partir de corpus annotés. La seconde approche a été par exemple retenu pour une tentative d’identification automatisée des notes de bas de page dans des corpus anglo-saxon du XVIIIe — une pratique éditoriale notablement différentes des notes actuelles, caractérisées par l’emploi de signes spécifiques en lieu et place des numéros.

J’ai eu recours à la première approche par règle pour extraire automatiquement les romans-feuilleton du Journal des débats. Le texte journalistique était alors suffisamment standardisé pour se contenter d’une définition relativement triviale (un texte, en bas du journal déparé par une marge importante — la grande barre sombre ne survit pas au processus de numérisation/ocr).

J’ai d’ailleurs pu constater que cette approche cesse de fonctionner correctement à partir du début du XXe siècle, signe parmi d’autres que l’économie générale des formes journalistiques était en train de changer profondément. Mes travaux actuels visent à aller plus loin que l’identification d’une seule forme journalistique pour reconstituer l’architecture éditoriale générale de la presse quotidienne au XIXe siècle (et, idéalement, au XXe siècle), en anticipant notamment les articulations régulières en forme et sémantique du texte — par exemple, les signatures sont toujours justifiées à droite et les titres sont toujours centrés.

J’ai beaucoup insisté sur la “modélisation éditoriale” car elle constitue un exemple très parlant visuellement, mais les mêmes principes peuvent être appliquées à d’autres formes culturelles. C’est évidemment le cas depuis déjà quelques temps pour les textes, notamment à la suite des recherches pionnières de Ted Underwood sur l’usage critique et « détourné » des classifications supervisées pour interroger la construction historique de la généricité. Il est de nouveau question de partir d’une définition plus ou moins naïve de certaines catégories textuelles pour repérer les phases de formation d’un genre et l’évolution de sa composition lexicale.

L’interrogation critique des modèles de classification permet de sortir d’une approche d’indexation pure pour soulever des questionnements scientifiques : où ces formes se sont-elles développées ? comment se généralisent-elles et à quels moment ? dans quel contexte éditorial ?

Le potentiel de la classification est peut-être encore plus important pour les formes visuelles. Contrairement aux textes les images ne sont pas préalablement indexées dans les bibliothèques patrimoniales. Sauf à disposer d’un paratexte explicite elles restent généralement introuvables, et même dans ces cas-là, il est difficile d’identifier précisément des régularités visuelles, qui ne relèvent pas forcément du sujet figuré mais aussi du mode de figuration. Les nouvelles techniques de classification automatisée rendent tout simplement possible une poétique historique de l’image à grande échelle.

Les méthodes informatisées s’intègrent d’autant plus naturellement dans ce projet que les régularités se déploient fréquemment sur une échelle temporelle ample. L’histoire éditoriale de la forme feuilleton commence vers la toute-fin du XVIIIe siècle et s’achève vers les années 1970 et 1980 en France (les occurrences les plus tardives que j’ai pu identifier se trouvent dans des périodiques régionaux des années 1970). Aux États-Unis la plupart des chercheurs en cultural analytics ont empiriquement acquis une expertise chronologique ample — souvent de 1800 voire 1700 à aujourd’hui.

Où suis-je ?

En bref, depuis quelques années, une bonne partie de mon travail de recherche consiste à “opérationnaliser” des objets éditoriaux et des concepts . Et je serais bien en peine de dire précisément à quelle discipline correspond cette activité. Ce n’est pas de l’histoire, de la littérature, de la sociologie, de l’histoire de l’art, de la linguistique ou de l’informatique mais quelque chose qui croise ces disciplines et un peu plus encore.

L’enjeu fondamental des nouvelles méthodes de “lecture distante” ou de “cultural analytics” va au-delà de l’intégration de l’outil numérique dans des pratiques de recherches préexistantes qui ne sont pas appelées à changer en profondeur. Il s’agit bel et bien de proposer une redéfinition des frontières scientifiques, principalement au sein des sciences humaines et sociales, via, notamment, l’articulation paradoxale et constante entre observation minutieuse des réalités poétiques, éditoriales et documentaires et, d’autre part, l’ambition d’historicisation à grande échelle de formes culturelles.

Les transformations les plus marquantes, de mon point-de-vue, concerne les pratiques quotidiennes de la recherche. La programmation implique inévitable une textualisation et une explicitation des regards de recherche et des méthodes de travail. Il ne suffit pas de repérer instantanément que le feuilleton est en bas de page ou que les signatures sont systématiquement alignées à droite, il faut l’exprimer clairement en pourcentage de page ou en pourcentage de colonnes.

L’ampleur des corpus analysé et le recours à la programmation implique également de repenser l’organisation de la journée. Au-delà d’une certaine taille l’automatisation n’est pas instantanée : elle peut prendre plusieurs heures voire plusieurs jours. Je constate ainsi que je suis de plus en plus amené à anticiper les tâches à accomplir pour qu’elles tournent en mon absence (notamment pendant la nuit).

Disons-le clairement ces pratiques de recherche sont encore marginales, même au sein des humanités numériques. Je suis de plus en plus convaincus qu’elles sont appelées à se généraliser. Certes, les outils sont encore mal adaptés, les compétences manquent à l’appel, les corpus plus ou moins disponibles et dans un état plus ou moins hétérogènes, mais il y a un facteur plus important : c’est très tentant. Lorsqu’on s’intéresse aux collections patrimoniales et aux archives au sens large l’on est inévitablement confronté à tout ce savoir latent que je viens de décrire. L’on se familiarise avec les règles éditoriales, les marqueurs lexicaux de la généricité (que nous avons inévitablement assimilés lorsque nous procédons par lecture flottante) ou les stéréotypes visuels que l’on se résigne à cantonner dans un vague arrière-plan culturel sans pouvoir imaginer de décrire systématiquement une telle masse documentaire en dehors de quelques échantillons ponctuels.